Evolución SEO en 2020

Una parte fundamental de mi trabajo es analizar constantemente cómo evoluciona Google. Cada año se pueden leer cientos de contenidos que hablan de hacia dónde evoluciona el SEO o sobre lo que dice Google que va a premiar, pero estas afirmaciones no siempre se corresponden con lo que finalmente Google acaba valorando o son afirmaciones cuya validez es solo parcial. Siempre intento por tanto verificar qué porcentaje de verdad hay en esa información y por tanto cómo debo enfocar o adaptar las nuevas estrategias.

En este post sencillamente quiero compartir algunas de mis conclusiones. Como titulares no parecerán gran cosa, soy consciente, pero son datos contrastados tras analizar decenas de proyectos tanto nuestros como de clientes y por tanto creo que son de valor.

También aprovecharé para hacer un repaso histórico de algunos factores SEO para tener una imagen completa de la evolución de Google durante las últimas 2 décadas.

Empecemos con uno que para mí supone un cambio enorme en la mecánica de Google:

Tabla de contenidos

El contenido de calidad gana peso

Creo que es la primera vez en mi vida que hago esta afirmación. De hecho, creé este blog precisamente porque veía que medio mundo le daba un peso al contenido que no tenía y veía necesario introducir el concepto de respuesta de usuario para poder explicar mejor el algoritmo de Google. Durante mucho tiempo he defendido que el contenido no era para nada el rey. El contenido era un medio que te podía servir para conseguir respuesta de usuario pero el contenido por sí solo tenía mucho menos peso de lo que parecía.

Pues bien, por primera vez en 17 años de profesión considero que:

El contenido de calidad gana peso por sí solo.

Para entender esta afirmación veo útil repasar qué papel ha jugado el contenido con el paso del tiempo.

Pre Panda (hasta 2011)

Hasta 2011 el contenido era una mera suma de palabras. El algoritmo de Google, resumiendo mucho, era solo SEO onpage + texto + links, poco más. Apenas importaba si el contenido era bueno o malo. Incluso en los primeros años, los más salvajes, podías colar con facilidad contenido automatizado y si le ponías unos pocos links, lo posicionabas. En estos años, por tanto, el contenido de calidad no era necesario, tan solo hacía falta texto y links.

Panda (desde 2011)

Panda supuso un cambio profundo. El algoritmo introdujo muchas señales que medían la reacción del usuario ante diferentes resultados de búsqueda. Si tu contenido era basura, el usuario lo notaría y rebotaría. Por tanto, hacer contenido de calidad era útil, pues conseguía mejorar la reacción/respuesta que el usuario tendría al ver tu contenido. Pero lo que Google medía no era directamente si el contenido era bueno o malo, sino la reacción del usuario ante dicho contenido. Hacer contenido de calidad era un medio para conseguir respuesta de usuario, pero no el fin último. De esta forma, podías encontrar mil ejemplos con mal contenido pero alta respuesta de usuario, y viceversa. Había correlación entre crear buen contenido y posicionar mejor, pero no implicación directa. En este blog he hablado bastante de este tema.

2019-2020

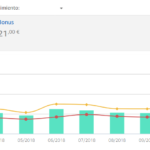

Lo que llevo observando ya muchos meses es algo diferente. Observo que el contenido posiciona directamente y no es solo un medio para otro fin. Crear un contenido de calidad tiene un impacto directo en el posicionamiento.

En el caso de portales SEO tipo micros o nichos, observo que un contenido de calidad posiciona mejor directamente. Antes no era así o al menos no de forma tan directa. Es como si finalmente Google hubiera desarrollado su IA suficientemente bien como para valorar la calidad.

En el caso de ecommerce la evolución es todavía más acentuada. Antes si tu tienda era la mejor (precio, atención, marca, etc) el contenido importaba menos. El blog, por ejemplo, era un extra, una manera de conseguir posicionar keywords adicionales mediante marketing de contenidos, pero las keywords transaccionales se posicionaban con respuesta de usuario y link building (y el onpage correcto, claro). Ahora crear buenos contenidos no solo ayuda a posicionar contenidos informativos sino también potencian el resto de la web ayudando a posicionar contenidos transaccionales. Es decir, buenos contenidos ayudan de manera directa al posicionamiento de un ecommerce.

Nota

Todo esto no ha sido algo repentino, ha sido una evolución lenta, y por supuesto hay mil variables más. Google afina sus variables diariamente pero mi conclusión es clara.

- Antes: Yo buscaba un contenido correcto a nivel onpage y que tuviera buena respuesta de usuario. El objetivo era la respuesta de usuario.

- Ahora: Quiero el mejor contenido posible, no solo el que tenga buena respuesta, sino uno que pueda considerarse el mejor posible. El objetivo ahora es doble: contenido de calidad y respuesta de usuario.

El link building agresivo incrementa su riesgo

Aquí también ha habido una evolución muy similar a la del contenido cambiando Panda por Penguin y calidad por naturalidad. Mismas fechas:

Pre Penguin (antes de 2012)

Hasta ese momento el link building que se hacía era salvaje: enlaces de menú, sidebar y footer, anchors exacto, baja necesidad de que los links estuvieran dentro de buenos artículos, etc. En resumen, el link building más eficiente era el muy agresivo.

Penguin (desde 2012)

La primera actualización Penguin (ha habido varias) llegó después de Panda. Buscaba detectar y frenar el spam, entre ellos el del link building. Desde entonces hemos tenido que hacer un link building más natural, combinando anchors agresivos con conservadores, enlazando desde portales de calidad, buscando similitud de temáticas al menos del artículo que te enlaza, etc. El link building más eficiente por tanto pasaba a ser más natural.

2019-2020

Lo que he notado en los últimos 12 meses es que:

Google se ha vuelvo muy exigente con el link building y castiga los patrones excesivamente agresivos.

Lo que ha funcionado durante 6-7 años tenemos que hacerlo evolucionar. Ahora estoy optando por anchors más naturales, mucho más marca y URL, y menos enlaces con anchor agresivo. Me preocupa también que el contenido que te enlaza sea de calidad y acabe posicionando. Intento evitar portales que Google puede identificar como granjas de enlaces, así como ciertas plataformas que están llenas de este tipo de granjas. Alterno enlaces dofollow con nofollow, y ahora también estoy introduciendo los sponsored. En definitiva busco un link más natural, más creíble, que aporte valor.

Riesgo vs eficiencia

Y un apunte: La estrategia descrita en el párrafo anterior busca una alta naturalidad y por tanto un riesgo muy bajo, pero no es la única posible y no siempre será la más rentable. Conforme hagamos link building más agresivo, incrementamos su eficiencia y el riesgo, y en ocasiones asumir un mínimo riesgo es más razonable que seguir una estrategia excesivamente conservadora.

Como ejemplo tendríamos los portales de afiliación de Amazon. Como ya he contado en la agencia hemos desarrollado y seguimos desarrollando decenas de portales de este tipo (también otros orientados a Adsense) y hemos probado con diferentes grados de agresividad. Los portales más rentables han sido aquellos donde más hemos forzado. Con una agresividad excesiva te arriesgas a una penalización (que es reversible) pero a cambio puedes generar mayores ingresos durante un cierto tiempo, y normalmente los números son favorables. Si durante 2 años estás facturando el doble y “como castigo” luego estás unos pocos meses facturando menos o nada, te puede salir a cuenta.

Por supuesto, habrá marcas que no puedan permitirse el más mínimo riesgo, pero sí es importante que sepamos que no hay una única estrategia de link building. Debemos saber que Google en 2020 castiga más que antes los patrones poco naturales, pero sabiendo eso podemos escoger en cada proyecto la estrategia que más nos beneficie.

Geolocalización de los resultados

Es sabido que desde hace años Google adapta sus resultados en función de tu ubicación, entre otras cosas, tanto los “normales” como los incrustados de Google Maps (más concretamente Google My Business). A esta adaptación la llamamos geolocalización.

Es importante recordar varios aspectos:

- Google geolocaliza algunas búsquedas, no todas. No es lo mismo buscar “pizzería” que “resultado quiniela”.

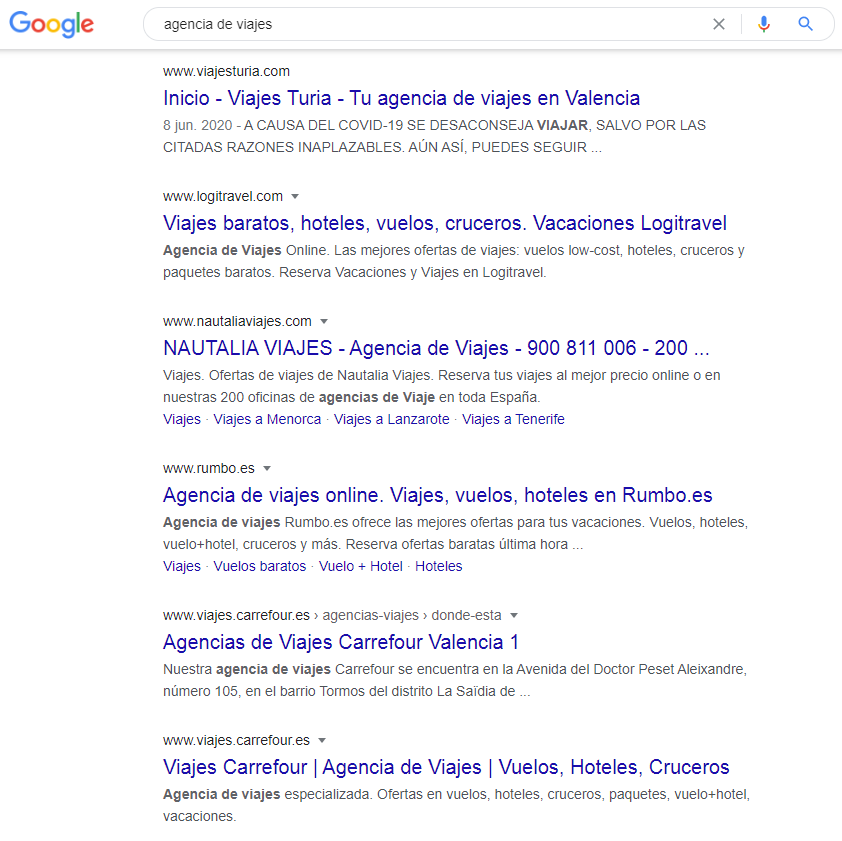

- El peso de la geolocalización varía en función de cada búsqueda (véase https://www.seoazul.com/seo-no-binario/), es decir, geolocaliza más o menos en función del tipo de búsqueda que hagas. Un ejemplo sería “agencia de viajes”, término que se geolocaliza pero menos que “pizzería”, lo que implica que mientras para el 2º término verás todo o casi todo resultados locales, para el 1º verás locales pero también resultados nacionales.

- Los resultados integrados de Google My Business (los del mapa) se geolocalizan mucho más que los resultados “normales”.

Todo esto no es algo nuevo, pero en este post quiero subrayar 2 puntos:

- Google ha ampliado el número de términos de búsqueda que geolocaliza.

- Google ha incrementado el peso de la geolocalización.

En definitiva, la geolocalización ha ganado peso y por tanto:

- Debemos esforzarnos en identificar qué términos se geolocalizan.

- Debemos entender que existe un peso o coeficiente de geolocalización para cada búsqueda.

- Debemos ajustar nuestra estrategia en función de si es un proyecto nacional, local o mixto.

- Es recomendable hacer tracking nacional (SemRush, Ahrefs, Sistrix) y local.

- Existirán términos nacionales para los que merecerá la pena hacer tracking nacional y también local en varias ciudades.

- Para tracking local me gusta usar SerpRobot. Es barato y muy cómodo. No es más que un interfaz, un intermediario entre la API de Google y tú, con su historial y su gráfica, pero muy práctico.

Canibalización positiva

Una forma de explotar de geolocalización es intentar un canibalización positiva. No siempre se consigue pues para ello necesitas mucha autoridad pero es una opción que como mínimo debe valorarse. En la captura anterior Carrefour lo consigue para la ubicación Valencia, por ejemplo.

Hiperpersonalización de resultados

Recordemos también que la geolocalización es solo una de las muchas personalizaciones que hace Google. Otra de la más importantes es diferenciar entre búsquedas de PC y móvil. Diferenciar por ubicación y dispositivos son las 2 más sencillas de trackear. Para algunos proyectos es útil hacer trackings de las keywords principales en varias ciudades y en PC/móvil.

También es conocido que Google adapta los resultados en función de tu historial de búsqueda e incluso de la hora del día. De hecho, debemos saber que SemRush, Sistrix, Ahrefs y cualquier herramienta de tracking te muestran resultados neutros, es decir, sin ubicación, ni horario, ni historial (tan solo dispositivo, eso sí). Ocurre con frecuencia la paradoja de que puedes estar primero para un keyword según esas herramientas pero luego no estarlo para ninguna ubicación, y por tanto no estar realmente nunca primero para esa keyword.

La conclusión es que debemos conocer que Google cada vez personaliza más sus resultados en función de diversas variables. Nuestro diagnóstico, por tanto, debe hacerse bajo ese conocimiento y evitar malinterpretar los datos neutros.

Valorar el Top 10 en su conjunto

Las primeras 2 tareas de un proyecto SEO son el diagnóstico y el diseño de una estrategia.

Para tener un diagnóstico debemos saber interpretar los resultados de Google y como parte de esto entender por qué una página posiciona en cierta posición para cierta búsqueda. Esto se hace analizando para cada portal diversos pilares del SEO:

- SEO clásico: SEO onpage + link building

- SEO moderno: SEO onpage + link building + respuesta de usuario

Pero hoy en día incluso el análisis moderno no explica todos los casos si analizamos cada portal de forma independiente dado que:

Actualmente es necesario analizar el Top 10 (y el Top 20) en su conjunto.

Para entender esta afirmación hay que tener en cuenta la intención de búsqueda (search intent) y el hecho de que:

Una misma búsqueda puede tener diferentes intenciones de búsqueda.

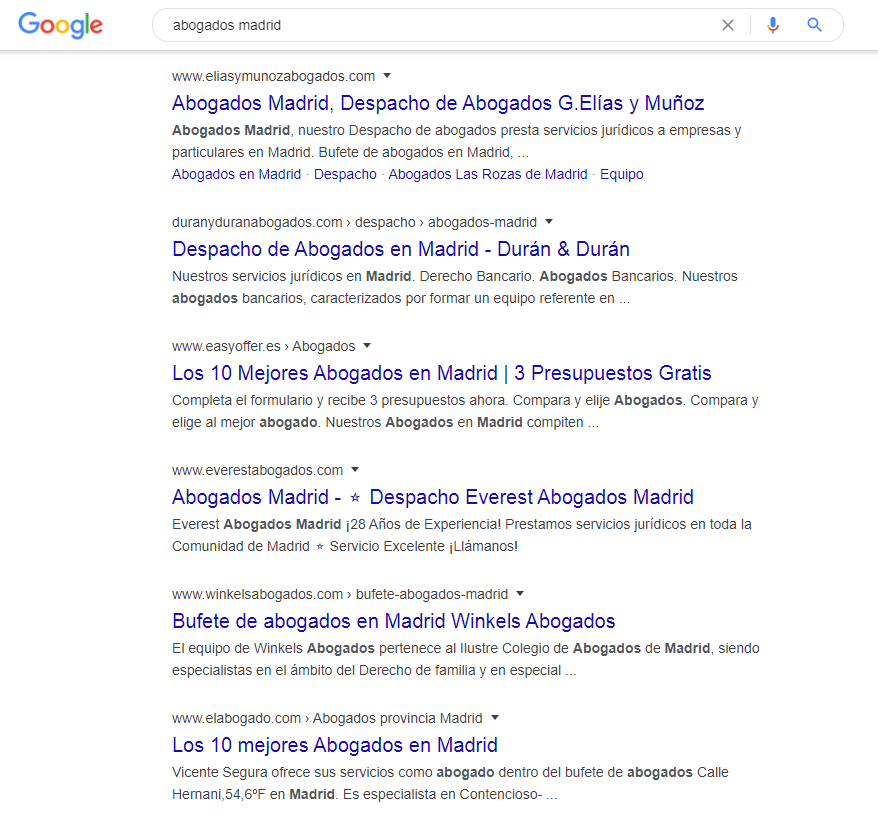

Cojamos como ejemplo abogados Madrid.

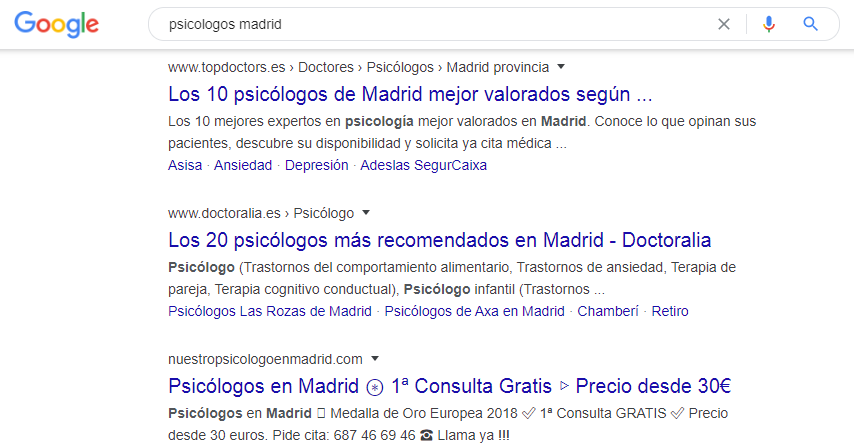

Para esta búsqueda habrá usuarios que pinchen en la página de un despacho concreto. Otros querrán un comparador. Ocurre similar con “psicologos madrid” aunque en este caso ganan peso los resultados de tipo listado/comparador:

Una buena referencia que sirve para la mayoría de búsquedas tipo “profesión + ciudad” es que el Top 10 lo completan resultados de tipo:

- Webs corporativas

- Listados/comparativas

- Marketplaces

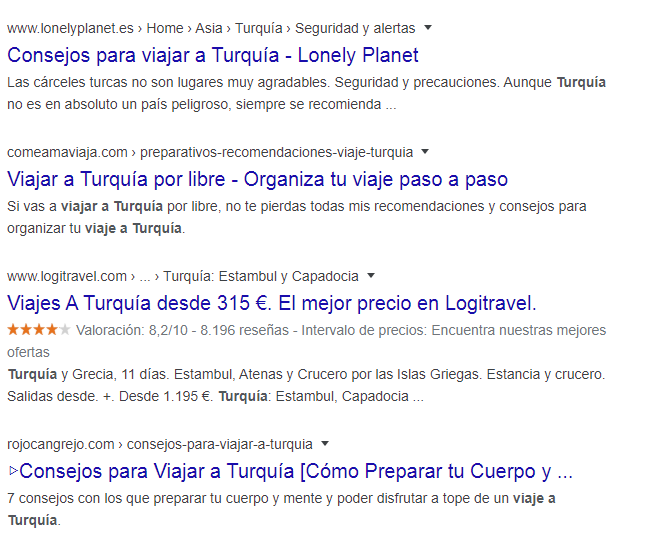

Otro tipo de búsquedas pueden tener un patrón diferente. Por ejemplo “viajar a turquia”, “viajes turquia” y en general una amplia mayoría de términos relacionados con turismo completan el Top 10 con resultados de tipo:

- Agencias de viajes

- Blogs de turismo

- Noticias

Y ya de forma mucho más amplia tenemos que hay búsquedas cuyo Top 10 son resultados de tipo:

- Informativo

- Transaccional

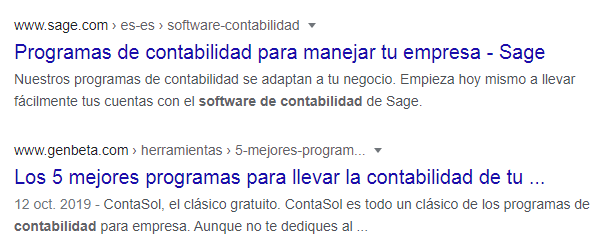

Como ejemplo, uno que ya usé: “software de contabilidad”.

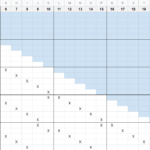

Pues bien, ¿por qué me interesan estos ejemplos y por qué digo que hay que evaluar el Top 10 en su conjunto? Pues porque la fórmula P = ROL no se cumple si analizamos cada portal por separado, hay que hacerlo de manera conjunta para el bloque del Top 10 y para el del Top 20 dado que:

Google busca satisfacer todas las intenciones de búsqueda con el Top 10.

Por afianzar conceptos, imaginemos que tengo un negocio y que para una intención de búsqueda el Top 10 Google ofrece 6 comparadores y 4 portales corporativos. Supongamos también que para ese término la intención de búsqueda mayoritaria es la de tipo comparativo. Digamos que nuestro portal tiene métricas inferiores a los 4 corporativos pero superiores a los 6 comparadores. ¿Qué ocurriría?

- Un análisis portal a portal sugeriría que nos merecemos estar en posiciones 5-7.

- Un análisis conjunto del Top 10 nos muestra que nos corresponde la posición 11.

Pero hay más conclusiones:

- Competimos sobre todo con los 4 corporativos y en menor medida con los listados.

- Si superamos en métricas a un resultado corporativo es posible que subamos varias posiciones, no solo 1.

Otro caso práctico es cuando no conseguimos posicionar una landing transaccional en el Top 10. Podría ocurrir que con métricas muy altas no conseguimos entrar por ejemplo porque esa keywords apenas admite 2-3 resultados transaccionales. Analizar el Top 10 en su conjunto nos podría sugerir que con mucho menos esfuerzo podríamos posicionar un contenido de tipo informativo y luego reconducir ese tráfico a nuestra landing transaccional (esto se llama marketing de contenidos).

Todo se repite nuevamente con los resultados del 11 al 20, es decir, observo este comportamiento en el Top 10 y en el Top 20.

En definitiva, para un correcto diagnóstico y una estrategia eficiente necesitamos:

- Analizar las intenciones de búsquedas asociadas a una keyword.

- Identificar los bloques de resultados del Top 10 asociados a cada intención de búsqueda.

- Determinar qué peso tiene cada bloque.

- Analizar nuestro contenido en base a estos bloques.

- Valorar atacar el Top con otro tipo de contenido (canibalización positiva).

- Repetir con el Top 20.

Conclusión

El 2020 trae una evolución importante y compleja de la IA de Google pero afortunadamente hay varios aspectos que se pueden identificar y potenciar. Se complica la tarea de diagnóstico y diseño de estrategia, y gana peso la calidad tanto en contenido como en link building.