Algoritmo Google Penguin 4.0: Un dato más

La verdad es que no tenía intención de hacer un post sobre Penguin 4.0. A estas alturas seguramente la mayoría de los lectores de este blog ya conoceréis que Penguin pasa a ser en tiempo real y granular, bien porque habéis leído el blog oficial de Google, o bien porque lo habéis leído en español en algún otro blog.

No veía interesante por tanto escribir sobre el tema si no tenía nada más que decir. Pero ha resultado que sí que tengo algo más que decir, dado que he podido observar un mismo comportamiento dentro de un tipo de negocios en un número de portales suficiente como para poderlo considerar un patrón.

Por supuesto los datos son sesgados, pues no he analizado la totalidad de los portales de Internet, pero sí merece la pena comentarlos. Aprovecharé, ahora sí, para hacer un post completo sobre Penguin 4.0 explicando en qué consiste y terminaré con una conclusión general sobre la evolución de Penguin. Si quieres ir directo al dato extra, pincha aquí.

Tabla de contenidos

¿Qué es Google Penguin (Pingüino)?

Penguin es el nombre de una actualización del algoritmo de Google que nació en 2012 y que está enfocado en detectar y penalizar el spam y especialmente los patrones de enlaces no naturales.

Desde ese momento ha habido varias actualizaciones:

- Penguin 1/Penguin 1.0: 24 de abril de 2012.

- Penguin 2/Penguin 1.1: 26 de mayo de 2012.

- Penguin 3/Penguin 1.2: 5 de octubre de 2012.

- Penguin 4/Penguin 2.0: 22 de mayo de 2013.

- Penguin 5/Penguin 2.1: 4 de octubre de 2013.

- Penguin 6/Penguin 3.0: 17 de octubre de 2014.

- Penguin 7/Penguin 4.0: 23 de septiembre de 2016.

No creo que merezca la pena repasar qué aporta cada actualización. Simplemente retengamos que en cada una de ellas se añaden nuevos datos o señales para detectar spam, especialmente (aunque no solo) el relacionado con enlaces spam.

¿Qué es Google Penguin 4.0?

Es la última actualización de Google Penguin, que incorpora 2 importantes cambios:

Penguin funcionará en tiempo real

Hasta ahora el efecto de Penguin se actualizaba periódicamente, por lo que el efecto de algunas acciones SEO tardaba un tiempo en verse reflejado.

Ahora Penguin forma parte del núcleo de Google y se actualizará en tiempo real al igual que muchas otras señales de su algoritmo. Detectará por tanto el spam mucho más rápido.

Penguin será más granular

Hasta ahora Penguin podía penalizar un portal entero si detectaba signos de spam. Ahora en vez de eso devaluará las señales spam y afectará a un nivel más concreto (páginas concretas, secciones, etc). Esto se traduce en el caso de los enlaces en restar o anular su valor, en vez de penalizarte el sitio entero.

Obviamente si devalúa la fuerza que recibes en varias secciones, esto podría afectar a todo tu portal, pero más como una consecuencia indirecta que como una penalización del algoritmo.

Efecto en diferentes sectores

Bueno, una vez repasado los conceptos básicos de Penguin, paso ahora sí a lo que yo he podido medir en base a cientos de portales. Insisto que esto no son conclusiones absolutas, sino parciales en base a los portales que gestionamos desde Softalian, pero dado que observamos un patrón y que es totalmente coherente con lo que anuncia Google, merece la pena considerarlo como dato fiable.

Agruparé los portales en 3 grupos que aglutinan la mayoría de los portales que trabajamos:

Grandes marcas en mercados de alta respuesta de usuario

Aquí no hemos notado nada, en ninguna de las temáticas que trabajamos, más allá del típico baile que existe cada semana y que puede deberse a cualquier acción nuestra o de la competencia.

La justificación que le doy es sencilla: nosotros no realizamos ningún tipo de spam ni publicamos enlaces de riesgo, pero tampoco lo hace la competencia. Tal vez lo hagan competidores más pequeños pero como las keywords importantes suelen ocuparse por grandes marcas, el efecto de una posible devaluación de esos competidores ha sido nulo.

Tal vez haya habido algún efecto pequeño, pero estos portales tienen mucho tráfico y la propia oscilación diaria, aunque porcentualmente sea casi nula, el valor absoluto puede ser mayor que dicho efecto. En definitiva, no observo nada en las grandes marcas que se pueda atribuir a esta actualización.

Portales temáticos

Tampoco hemos observado nada en nuestros propios portales temáticos, ni en los de micro nicho (micros) ni en los portales más grandes. El motivo parece ser el mismo. Los portales que suelen copar las primeras posiciones suelen ser portales de cierta calidad y con cierta respuesta de usuario, por lo que no hay demasiado spam que penalizar.

Portales pequeños y medianos en mercados de alta respuesta de usuario

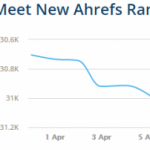

Aquí sí hemos notado importantes cambios y el motivo también concuerda con lo que anuncia Penguin 4.0. En este tipo de negocios sí que había portales de baja calidad que se habían posicionado utilizando técnicas muy agresivas. A diferencia del primer grupo, aquí ya no compiten solo con grandes marcas y por tanto tenían hueco donde colarse, al menos durante un tiempo.

Con la llegada de Penguin casi todos estos portales han caído varias páginas permitiendo a nuestros portales subir varias posiciones. Realmente no es que hayamos subido nosotros, sino que nuestra competencia spam se ha hundido y ahora competimos los portales que, por decirlo de alguna manera, “hacíamos las cosas bien”. En cierto modo siempre ha sido así, el spam se suele colar una temporada entre los resultados de calidad y luego se hunde, pero si ahora Penguin pasa a ser en tiempo real, nos desharemos de este tipo de portales mucho antes, o incluso puede que estos desistan.

Ahora se observa un orden más natural en las SERP, que queda más o menos así:

Para keywords importantes:

- Grandes marcas

- Portales medianos

- Spam

Para keywords secundarias

- Grandes marcas y portales pequeños mezclados según los objetivos de cada portal

- Spam

Llegado este punto os recomiendo repasar seoazul.com/grandes-marcas-vs-portales-pequenos/

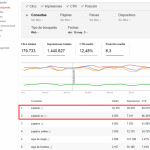

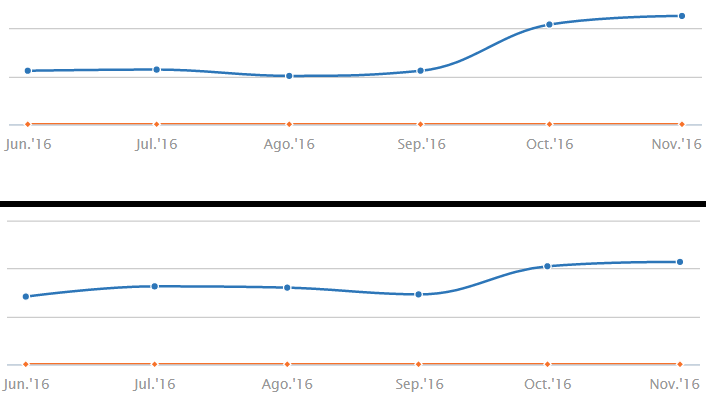

Como os podéis imaginar, no puedo citar dominios exactos por el mismo motivo de siempre, pero os copio 2 capturas de SemRush recortadas que muestra el tipo de patrón que hemos observado.

La verdad es que Penguin 4 ha sido una buena noticia para todos los que hacemos SEO natural, pues Google nos vuelve a insistir en que cada vez es más rentable intentar hacer portales de calidad antes que spam.

Google Disavow

Una pregunta natural que surge es: Si Google actúa más devaluando enlaces y menos penalizando sitios enteros, ¿significa esto que ya no es necesario usar Disavow?

La primera respuesta debe ser que no hay una conclusión absoluta actualmente. Ni Google ha afirmado que debemos dejar de usar Disavow ni hay datos concluyentes para afirmar que ya no sirve para nada. Sin embargo, hay 2 datos que sí me atrevo a afirmar con bastante seguridad: (para entender la diferencia entre “conclusión absoluta” y “bastante seguridad” te recomiendo seoazul.com/como-entender-el-seo/):

En primer lugar sí que creo que ahora Disavow es menos necesario que hace años. Sí que he observado que Google detecta cada vez mejor qué enlaces son spam y directamente los ignora. Esto no es nuevo de ahora. Llevo tiempo observando que algunos portales reciben algunos enlaces claramente tóxicos sin que esto suponga ningún perjuicio en el posicionamiento.

Si ahora, adicionalmente, Google hace una afirmación en esta dirección, sirve para reafirmar mis conclusiones.

En segundo lugar, “menos” no es “nada”. Disavow todavía puede ser útil, en concreto ante penalizaciones manuales. Yo desde luego no he quitado los ficheros disavow de aquellos portales que lo han necesitado.

La conclusión es que todo apunta a que Google cada vez será más inteligente y anulará los enlaces spam, pero que a día de hoy Disavow todavía puede ser útil en determinados casos, aunque menos que hace años.

Tendencia histórica y conclusión

Desde que salió Panda y Penguin en 2011/2012 Google siempre sigue la misma tendencia:

Google quiere que nos sea más rentable hacer calidad que hacer basura.

Hasta 2010 esto no fue así, pues era muy rentable hacer decenas de portales basura, enlazarlos con ciertas técnicas y monetizar. Pero cada año, con cada Panda o Penguin, Google insiste y mejora su algoritmo para que la calidad prevalezca.

¿Significa esto que no podemos hacer spam, SEO agresivo o técnicas que Google no quiere? No, podemos seguir haciéndolas. De hecho algunas funcionan todavía, y para cuando Google bloquee estas, seguramente encontraremos otras. Pero ésta no es la pregunta correcta. La que debemos hacernos es: ¿Qué es más rentable?

Cada uno elegirá la opción que prefiera o conozca más, pero debemos tener presente que:

La tendencia es que cada vez más prime la calidad sobre el spam.

Y ahora te pregunto yo a ti: ¿Has notado algo con este Penguin?